在上一篇將本地HuggingFace Hub設置完成之後,我們的帳號就等於有連接到本地了

那我們現在就開始進行模型的部屬使用!

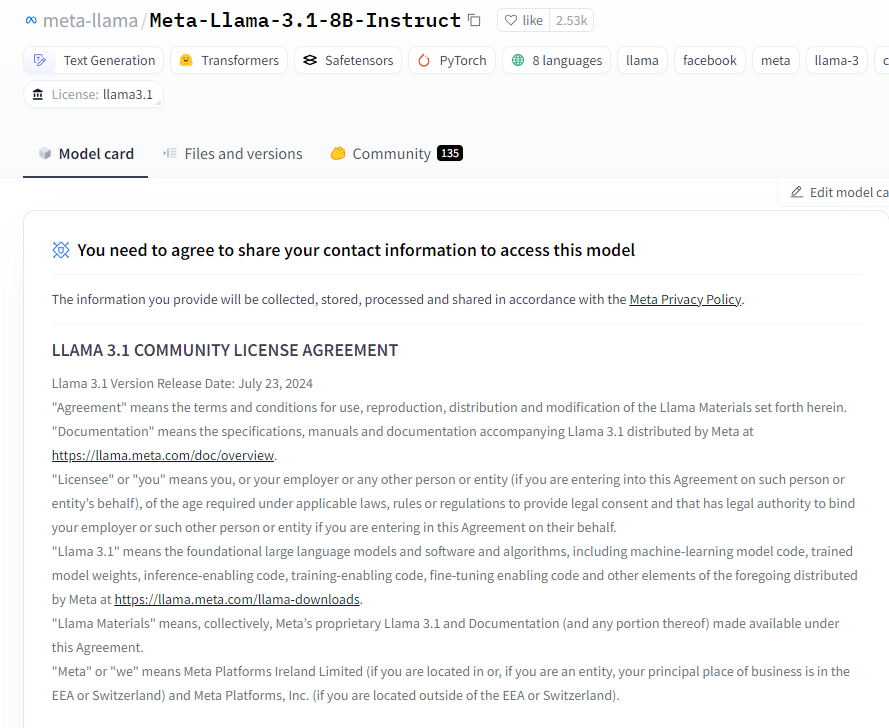

首先,先去 HuggingFace 你選擇的模型的Model card查看資訊

這邊以llama為例,通常這些熱門的開源模型就會需要申請權限

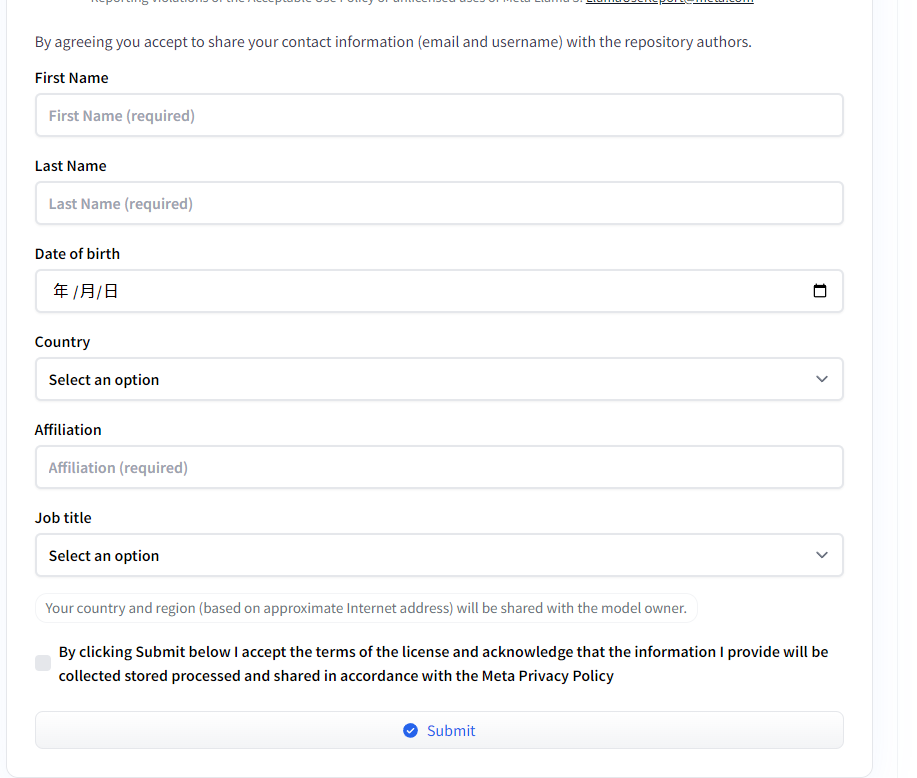

像這樣,這邊就需要將資料填一填並送出申請

快的話幾個小時內就會通過了!

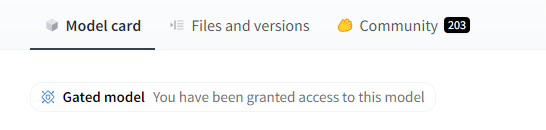

通過後再去model card這邊看,就會看到以下圖示

這樣就可以在你的專案內去使用這個模型了~

假如沒有權限的話,你在專案中執行程式就會跳error了

接著我們就可以在專案裡面開始執行了

這邊我們先來介紹transformer的一個函數,叫做pipeline

pipeline就是一個讓你簡易的使用模型的工具,並且能夠設定各種參數,像是task任務種類,指定model、運行模型的設備,或是一些模型output的參數等等

並且使用時,若是先前沒有下載過現在用的模型,他就會自動從huggingface尚將模型下載下來存在本地,之後在使用時就會直接使用了。

這邊我們就來先簡易的使用看看

import transformers

// HuggingFace模型ID

model_id = "meta-llama/Meta-Llama-3-8B"

pipeline = transformers.pipeline(task="text-generation", model=model_id, tokenizer=model_id)

output = pipeline("Hey, how are you doing today?")

print(output)

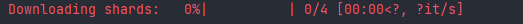

首次使用模型的話會需要等待他將模型下載完畢

下載完並且模型跑完之後,模型的response就會print出來了!

這樣我們就完成最簡易使用transformer在本地部屬模型並且交互了!

在之後的篇幅中會在使用此方法來進行更多應用及延伸!